OpenAI创始人Sam Altman访谈揭示:GPT-3可能会开源,而缩放法则可加速构建AGI

人工智能初创公司Humanloop的CEO Raza Habib在推特上整理了最近一次访谈的重点,其中提到OpenAI掌舵人Sam Altman回应主持人关于API可靠性和速度的不满时说:“我们非常缺GPU。”

推特地址:

https://twitter.com/dr_cintas/status/1664281914948337664

在这次访谈中,Altman还公布了最近两年的GPT计划,例如2023年的计划是降低GPT-4的成本,以及提高响应速度,其他还包括:

1.更长的上下文窗口,可能会支持100w的token;

2.微调API,帮助开发人员更好的开发;

3.支持会话状态的API,即支持会话状态的API。

2024年的计划中提到让GPT-4支持多模态,之所以推迟到2024年,就是因为太缺GPU了。

在访谈中,Altman 还提到他们一直在考虑是否开源GPT-3,毋容置疑开源是非常重要的。同时,他还表达了现在的AI模型并没有那么危险,虽然对未来的模型进行监管非常重要,但是禁止开发是一个非常大的错误观点。

Raza Habib原本将这次访谈的更多详细信息公布到了Humanloop,但文摘菌今早查看,网页已经404了。据国内微博@宝玉xp翻译,他还提到了关于大模型未来发展的缩放法则:

OpenAI的内部数据表明,模型性能的缩放法则继续有效,使模型更大将继续产生性能。缩放的速度不能维持,因为OpenAI在短短几年内已经将模型扩大了数百万倍,未来这样做将不可持续。这并不意味着OpenAI不会继续尝试使模型更大,只是意味着它们可能每年只会增加一倍或两倍,而不是增加许多个数量级。

缩放继续有效的事实对AGI开发的时间线有重要的影响。缩放假设是我们可能已经有了构建AGI所需的大部分部件,剩下的大部分工作将是将现有的方法扩展到更大的模型和更大的数据集。如果缩放的时代结束了,那么我们可能应该预期AGI会更远。缩放法则继续有效强烈暗示了更短的时间线。

显然,缩放法则是通往AGI的最快路径。

什么是缩放法则?

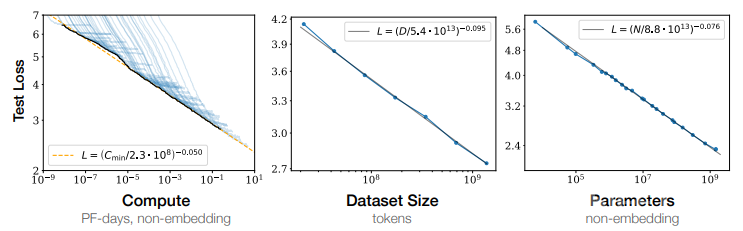

缩放法则,英文名称Scaling Laws,是一种现象描述,大意是指:语言模型的效果与参数量、数据量、计算量基本呈平滑的幂定律。

换句话说,随着模型的参数量(Parameters)、参与训练的数据量(Tokens)以及训练过程累积的计算量(FLOPS)的指数性增大, 模型在测试集上的 Loss 就线性降低,也就意味着模型的效果越好。

图注:当没有被其他两个因素限制时,实证性能与每个单独因素都呈现出幂律关系。

在2022 年,DeepMind 在 ScalingLaw 里又做了进一步分析。研究通过定量的实验验证,语言模型训练数据大小,应该和模型参数量大小等比放大。在计算总量不变的情况下,模型训练的效果在参数量和训练数据量当中有个最优平衡点,曲线下面的最低点是在参数规模和训练数据量当中有个非常好的折中点。

OpeaAI的成功和GPT-4

OpenAI最初是一个非盈利性人工智能研究实验室,2016年获得了萨姆•奥尔特曼和埃隆•马斯克10亿美元的资助。

2019年OpenAI转型为盈利性人工智能研究实验室,以吸收投资者的资金。

在实验室支持其研究的资金已所剩无几的时候,微软又宣布将在实验室投资10亿美元。

OpenAI推出的GPT系列,每一个版本都能引起业界狂欢,在微软Build 2023开发者大会上,OpenAI的创始人Andrej Karpthy做了演讲:State of GPT(GPT的现状),表示他们一直把大模型当做“人脑”来训练 。

Andrej提到,可以把当前LLM大语言模型比喻为人类思考模式的系统一(快系统),这是相对于反应慢但具有更长线推理的系统二(慢系统)而言。

“系统一是一个快速的自动过程,我认为有点对应于 LLM,只是对标记进行抽样。

系统二是大脑中较慢的、经过深思熟虑的计划部分。

而prompt工程,基本上是希望让LLM恢复一些我们大脑中具有的能力。”

Andrej Karpthy还提到,GPT-4 是一个了不起的人工制品,他非常感谢它的存在。它在很多领域都有大量的知识,它可以做数学、代码等等,所有这些功能都触手可及。

而CEO Altman 表示,在早期的时候,GPT-4 非常慢,还有bug,很多事情做得不好。但是,最早期的计算机也是这样,它们仍然指向了我们生活中将要变得非常重要的东西的道路,尽管需要几十年的时间才能发展。

如此看来,OpenAI是一家坚持梦想的机构,且想把事情做到极致的公司。

正如微软亚洲研究院前副院长、澜舟科技创始人周明在一次采访中提到的:

OpenAI最大的功绩是把各方面做到极致,是集成创新的典范。

世界上有几类人,有人就是要研究底层创新。有的是在底层创新上做应用,一般的应用是解决单项任务。还有的是做集成创新,把所有工作、应用、算法都在一个大平台上体现,形成里程碑。OpenAI 恰好集成创新做得非常好。