AI视频生成大爆发,快手可灵和Minimax赶超Sora

2023年是AI视频生成的爆发之年,各种技术路线不断涌现,推动视频生成从实验阶段迈向实用化。2024年,OpenAI推出的Sora模型以其创新的DiT(Diffusion Transformer)架构引领行业发展,推动技术逐步走向成熟。随后,快手的Kling AI展示了生成两分钟长视频的能力,Minimax的海螺则实现了高清视频生成,进一步提升了行业标准。这些突破不仅加速了视频生成技术的进步,也为其商业化落地奠定了坚实的基础。 OpenAI Sora由一个仅15人的核心团队打造,核心负责人Bill Peebles在伯克利获得博士学位,师从计算机视觉专家Alyosha Efros。博士期间,他在Meta实习半年,与谢赛宁合作发表了结合Transformer与扩散模型的DiT架构论文。Transformer的优势在于其可扩展性,不仅继承了在语言领域的扩展规律,也让Sora从大量数据中学习复杂视频关系,建立视觉领域的扩展体系。 AI视频生成领域的主要力量包括科技巨头、创业公司和开源项目,共同推动了技术的快速发展。科技巨头凭借资金、技术和人才优势,长期投资研发,构建从底层模型到应用层的全方位技术储备,展现出生态优势。开源项目则为整个领域提供了重要的技术基础和社区支持。而创业公司则凭借创新速度和产品迭代的灵活性崭露头角,迅速崛起。 ZP跟踪测试了快手的Kling AI、Minimax的海螺Al-abab-video-1。首先与Sora官网的Prompt生成的视频进行对比,发现效果绝对不输甚至更优;其次对比了7月份Kling AI的1.0版本和新出的1.5版本,三个月间Kling AI进步显著,尤其是文字生成视频方面。国内公司后发而先至,快手Kling AI和Minimax的海螺AI在综合性能上甚至超越了Sora、Runway等竞争对手。

视频生成(Video Generation)是指利用计算机算法和技术生成逼真的视频内容,通过模拟人类视觉感知和动作行为,以自动生成连续的视觉流,通常涉及从静态或动态输入数据中合成新的视觉内容,以满足特定的需求或创意目的。

2023年,a16z发布了文章《Why 2023 Was AI Video’s Breakout Year, and What to Expect in 2024》,指出2023年是AI视频生成的突破年,短短一年内,从无到有涌现出数十个文本生成视频产品,虽然大部分产品生成的短视频存在质量不均的问题,但技术进步的速度引人注目。a16z预测2024年该领域将继续发展,特别是在视频生成的控制性、时间一致性以及视频时长等问题上取得突破。

果然不负所望,今年2月,OpenAI发布了视频生成模型Sora,采用Transformer与扩散模型结合的创新方法,这一架构使得Sora能够生成高质量的长视频,维持时间和空间上的一致性,特别是在动态场景的3D一致性和长时依赖关系处理方面表现卓越,成为当时最为先进的视频生成模型之一,并推动了视频生成领域的技术前沿。

02 Why Now?

百花齐放的2023

2023年可以说是视频生成技术的百花齐放之年,各大公司和研究团队纷纷推出创新性的视频生成工具,展现了不同的技术路线和亮点。例如,Meta的“Make-A-Video”通过加速训练流程和不依赖文本-视频数据而脱颖而出;Runway的Gen-1和Gen-2模型突破了风格化和无参考视频生成;而NVIDIA的Video LDM则在高分辨率视频生成方面实现了技术突破。尽管这些方法在细节上各有创新,但在生成效果上,彼此之间的差距并不显著。

2022年9月,Meta发布最新的T2V(Text-to-Video)工具“Make-A-Video”,Make-A-Video 具有三个优点:(1) 它加速了 T2V 模型的训练(它不需要从头开始学习视觉和多模态表示),(2)它不需要成对的文本-视频数据,以及(3)生成的视频继承了当今图像生成模型的广阔性(美学、奇幻描绘等的多样性)。

2023年2月,Runway公司发布Gen-1模型,Gen-1模型在风格化、故事板、遮罩、渲染和定制化方面取得技术突破。Gen-1 主要是对现有的影片素材(用户仍需上传现有视频)进行转换,让使用者可以用文字指令来修改影片中的物件颜色、图像风格等。

2023年3月,Runway公司发布Gen-2模型,Text-to-video AI模型,不需要先提供任何影片或图像作为参考,只需要输入文字指令提示即可生成全新的影片。

2023年5月,Stability AI上线Stable Animation功能,这个功能允许用户通过文本提示、现有图像或现有视频来生成动画。Stable Animation SDK 是一个强大的文本到动画工具,它为艺术家和开发者提供了三种不同的动画创建方式:(1)文本到动画:用户输入文本提示,并调整各种参数以产生动画;(2)文本输入+初始图像输入:用户提供一个作为动画起点的初始图像。文本提示与图像结合使用,产生最终输出动画;(3)输入视频+文本输入:用户提供一个作为动画基础的初始视频。通过调整各种参数,得到一段由文本提示指导的输出动画。

2023年6月,NVIDIA发表 'Align your Latents' 论文,该论文介绍了一种名为 Video Latent Diffusion Models (Video LDMs) 的技术,用于高分辨率视频合成。这项工作通过将潜在扩散模型 (LDM) 应用于视频生成任务,有效地缓解了生成高分辨率视频所需的巨大计算和内存需求。

2023年8月,Runway上线“Extend Video'功能,这个功能允许用户将Gen-2视频的时长增加额外的4秒钟,每个视频最多可以延长3次,即最长可以达到16秒。

2023年9月,Runway 进一步更新了 Gen-2,增加了统称为“Director Mode”的新功能,这项功能允许用户在Runway AI生成的视频中自定义“相机”的运动方向和速度/强度,模拟了真实相机拍摄的效果,但所有内容都是由Runway的Gen-2模型即时创建的。用户可以根据自己的需求选择不同的“相机”运动方向,包括水平、垂直、缩放,甚至滚动控制。此外,用户还可以调整运动的速度,以及使用“Extend”功能来重复现有的相机方向,以便在扩展视频时能够无缝地继续运动,最长可达16秒。这为AI视频制作提供了更多的创造性控制选项。

2023年9月,扩展插件AnimateDiff模型发布,它采用控制模块来影响Stable Diffusion模型,它能为Stable Diffusion WebUI带来动态视频生成的能力。这个插件的主要目标是将动画生成能力与Stable Diffusion WebUI结合,并结合ControlNet的功能,打造一个易用的AI视频工具集。用户可以像生成静态图像一样轻松地生成GIF动画。

2023年10月,腾讯发布VideoCrafter,提供了两种开放扩散模型,分别用于文本到视频(T2V)和图像到视频(I2V)任务。T2V模型能够生成具有1024*576分辨率的逼真且具有电影质量的视频,在质量方面胜过其他开源T2V模型。而I2V模型则旨在生成与提供的参考图像内容严格一致的视频,保留其内容、结构和风格。这是第一个能够将给定图像转化为视频剪辑并保持内容保存约束的开源I2V基础模型。

2023年11月,Meta推出两款生成式AI模型:Emu Video和Emu Edit。Emu Video可以根据文本提示生成短视频,而Emu Edit则可以根据基于文本的指令编辑图像。

2023年11月,Alibaba 发布 'Animate Anything' 论文,提出了一种新的框架,这个框架能够保持角色外观的时间一致性,并且能够控制角色的动作。其技术贡献主要在于:通过空间注意力机制合并参考图像的细节特征,保持角色外观的一致性;引入Pose Guider,实现对角色动作的精细控制,确保视频帧之间的平滑过渡;采用有效时间建模方法,模拟连续且平滑的时间运动过程。

2023年11月,ByteDance发布论文'Make Pixels Dance' ,推出视频生成模型“PixelDance”,PixelDance提出了两种不同的视频生成模式,第一种是Basic Mode,用户只需要提供一张指导图片+文本描述,PixelDance就可以生成有高度一致性且有丰富动态性的视频,其中指导图片可以是真实图片,也可以利用现有的文生图模型生成。第二种是Magic Mode,在这种模式下,用户需要提供两张指导图片+文本描述,可以更好地生成更有难度的视频内容。而达到这样突出的视频生成效果,并没有依赖复杂的数据集和大规模的模型训练,PixelDance在公开的WebVid-10M数据集上仅用1.5B大小的模型就达到了上述效果。

2023年11月,Stability.ai发布开源视频生成模型Stable Video Diffusion (SVD),Stable Video Diffusion是在文生图模型Stable Diffusion 2.1 的基础上添加了和Video LDM相同的视频模块微调而成的一套视频生成模型。

2023年11月,Pika 1.0正式公开发布早期测试版。Pika 1.0支持文本生成视频、图像生成视频以及视频生成视频,并且附带工具可延长现有视频的长度或将其转换为不同的风格。

2023年11月,ByteDance的研究人员发布“MagicAnimate”论文,它能够根据用户指定的人物图片和动作序列生成对应的动效视频。简单来说,用户只需提供一张人物照片,再配合骨骼动画引导,就能生成自然的动画视频。它提供的舞蹈视频解决方案中具有高度的一致性。

2023年12月,由斯坦福大学李飞飞的团队与Google合作推出W.A.L.T文生视频模型,该模型利用 Transformer架构与潜在扩散模型相结合,在一个共享潜在空间中压缩图像和视频,从而降低计算要求并提高训练效率。W.A.L.T 能够根据文本提示生成逼真的视频,并且在视频生成基准测试如UCF-101 和 Kinetics-600、图像生成基准测试如ImageNet上实现了最先进的性能。

2023年12月,Google发布VideoPoet论文,该论文提出了一种专门用于视频生成的大语言模型。它能够处理包括图像、视频、文本和音频在内的多模态输入,并在预训练和任务特定适应的两个阶段中进行训练。VideoPoet的关键特点包括能够生成高保真度的动作,并且支持零样本视频生成。该模型在各种视频生成任务中展现了最新的技术能力,尤其是在生成高保真度动作方面。

2023年12月,Meta推出“Fairy”视频合成模型,Fairy模型的核心是“锚点式跨帧注意力”机制,这种机制可以在帧之间隐式传播扩散特征,确保时间上的连贯性和高保真度合成。Fairy能够以极快的速度生成视频,生成120帧512×384像素的视频(相当于4秒长,30帧每秒)仅需14秒,比以前的方法快至少44倍。Fairy模型在处理视频时,能够接受不同长宽比的输入,并将较长尺寸的输入分辨率重新扩展为512像素,同时保持长宽比不变。它能够对输入视频的所有帧进行编辑,而不进行下采样,所有计算可以在8块A100 GPU上分配完成。在用户研究中,涉及1000个生成样本的评估结果显示,Fairy生成的视频质量优于现有方法。

技术路线开始收敛的2024

2024年可以被称为视频生成的元年,自OpenAI发布突破性模型Sora以来,视频生成技术路线逐渐收敛,进一步推动了整个行业的进步。随后,快手的Kling AI生成两分钟长视频的能力,Minimax的海螺的高清视频生成能力,进一步提升了行业标准。随着国内外模型的相继突破,视频生成技术距离大规模商业化落地更近了一步,推动了创意内容生产的全新革命。

2024年2月,OpenAI推出了Sora,这是一个突破性的视频生成模型,DIT架构通过将扩散模型的逐步生成过程与Transformer的强大上下文理解能力相结合,显著提高了视频生成的效果。能够模拟动态相机运动,并保持三维一致性。Sora可以生成复杂的视频序列,在对象或角色移动或暂时消失的情况下,依然保持其一致性。Sora还支持互动模拟,例如在视频游戏《Minecraft》中,能够同时控制角色并实时渲染游戏环境。

2024年5月,在Google I/O大会上,Google发布了Veo,Veo能够生成1080p分辨率的视频,支持多种电影风格,并且可以理解自然语言提示。它能够生成超过一分钟的高质量视频,支持动态镜头拍摄,如航拍和延时摄影。Veo为创作者提供了更多的视频控制权,生成的视频在动作和场景连续性方面非常逼真。

2024年6月,快手推出了Kling AI(可灵),并集成到其视频编辑应用Kwaiying中。Kling AI可以生成两分钟的视频,超过了当时OpenAI的Sora模型的能力,Kling AI因其高质量的视频输出和平滑的镜头转换而备受赞誉,迅速成为中国顶尖的AI视频生成模型之一。

2024年9月,字节推出了两个AI视频生成模型:PixelDance和Seaweed,它们基于字节跳动自研的DiT(Document Image Transformer)架构。这些模型支持多摄像头控制(如缩放、平移、旋转和跟踪),并能生成3D动画、2D动画和传统艺术风格等多种类型的视频。

2024年9月,MiniMax发布AI高清视频生成模型技术:abab-video-1。用户目前可以在海螺AI官网免费体验生成包含文字的视频,最高支持原生1280*720的25fps,拥有电影感镜头移动。

03 竞争格局

科技大厂

在AI视频生成领域,科技巨头凭借其雄厚的资金实力,能够进行长期且持续的投资与研发。例如,腾讯的混元大模型就是采用全自研模式,这种模式需要投入大量的人力、物力和算力。此外,在吸引顶尖人才方面也具有明显优势,科技巨头的研究院在学术领域通常有着深厚的积累,能够产出大量高质量的研究成果。这一点从Meta、NVIDIA、Google、阿里巴巴等公司在论文发表方面的活跃度就可见一斑。

科技巨头不仅在技术研发上有着深厚的积累,而且在构建生态系统方面也展现出明显的优势。他们凭借多年的技术积累,在AI视频生成领域拥有从底层模型到应用层面的全方位技术储备。在模型训练方面,也能够与内部业务团队发挥协同效应,更有针对性地对模型进行调整,以适应不同的业务需求。这种协同效应使得科技巨头在AI视频生成领域具有明显的生态优势,能够快速响应市场变化,推动技术的实际应用和商业化进程。

但是,由于决策层级较多和流程繁琐,科技巨头在新产品开发的速度上可能不如创业公司迅速。并且,大公司往往采取更为谨慎的策略,在新产品推向市场之前,需要进行详尽的测试和验证,以确保产品的质量和性能。这种稳健的做法虽然有助于维护品牌形象和市场地位,但也可能导致产品迭代的速度不如灵活敏捷的创业公司。

开源项目

AI视频生成领域正迅速发展,开源项目在这一进程中扮演了重要角色。这些项目通常由学术机构、研究机构或技术公司发起,旨在推动视频生成技术的发展,并提供一个共享、协作的平台,让开发者和研究人员能够轻松访问和使用先进的视频生成模型,而并不承担营收的任务。

它们通常具有强大的社区支持,不断有新的贡献和改进被加入到项目中。此外,这些项目通常具有高度的灵活性和可定制性,允许用户根据自己的需求调整模型和参数。

创业公司

在AI视频生成领域,创业公司凭借其创新技术和快速迭代能力,已经成为该赛道最重要的玩家。国外如Runway(Gen-3 Alpha)和Pika Labs凭借其先发优势,以画质和创新的视频内容赢得了市场的认可。此外,Sora在视频生成质量、分辨率以及文本语义的还原度上也表现出色,并且能够制作长达60秒的视频内容。

中国的视频生成创业公司也开始崭露头角,比如,Minimax的海螺AI—abab-video-1,获得了海内外用户的广泛好评,特别是在运动场景的生成方面,海螺AI展现出了卓越的能力,其在人体动作的流畅度和逼真度上的表现,甚至超越了Runway、Luma AI等竞争对手。

在镜头控制、运动控制、音频编辑等方面,创业公司各自展现出了特色和侧重点,例如,Neural Frames的音频反应功能,能够生成与音乐节奏和情感相匹配的视频内容,在数字艺术制作等方面有其独特的优势。相较于科技巨头们,创业公司往往能够快速响应市场需求,推出各种产品的新玩法,并快速迭代改进。

然而,创业公司也面临着寻找PMF、提升视频一致性、降低算力成本、提高推理速度、商业化等挑战。尽管如此,它们的快速崛起已经证明了在AI视频生成领域,创业公司具有不可忽视的影响力和市场潜力。

04 技术先驱:OpenAI-Sora

团队

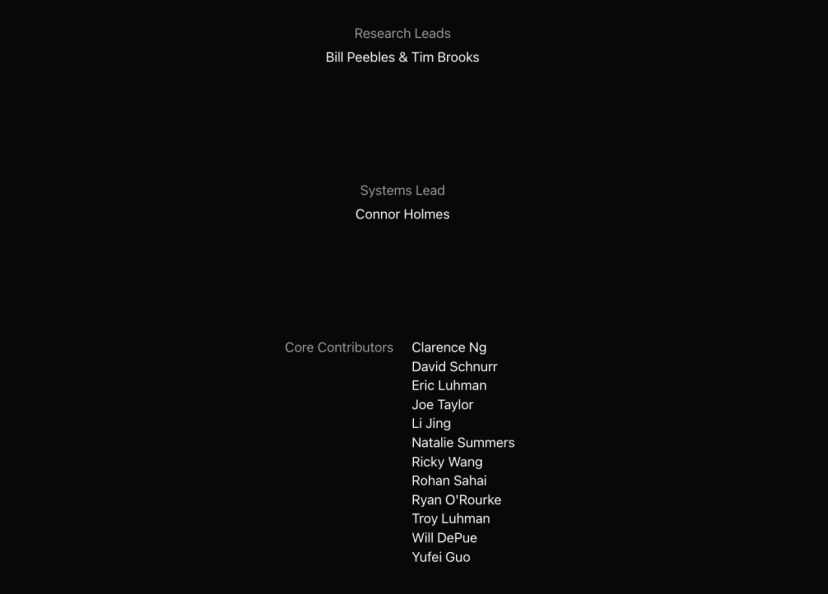

项目负责人有2位,他们是Bill Peebles和Tim Brooks

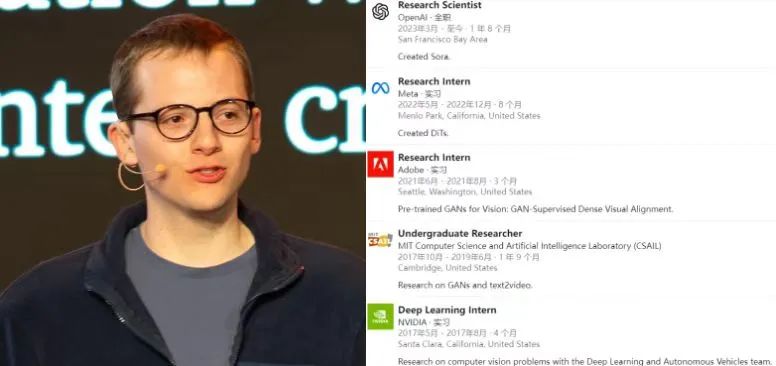

Bill Peebles:Bill是OpenAI的研究科学家,负责领导Sora项目,该项目专注于视频生成和世界模拟。他在伯克利AI研究所(Berkeley AI Research)完成了博士学位,导师是Alyosha Efros。他的研究领域涵盖大规模生成模型,并曾在FAIR、NVIDIA等知名公司实习。

2022年5月,Bill到Meta进行了为期半年的实习,和谢赛宁合作发表了DiT模型,首次将Transformer与扩散模型结合到了一起,该成果被ICCV 2023录用为Oral论文。OpenAI此次发布的Sora正是基于DiT构建的。

Tim Brooks:Tim是Sora项目的另一位领导者,同样是OpenAI的研究科学家。他在伯克利AI研究所获得博士学位,专注于图像编辑领域的AI模型(如InstructPix2Pix)。加入OpenAI后,相继参与了DALL-E 3和Sora的工作。在这个月,Tim从OpenAI离职去了Google的AI研究部门DeepMind。

系统负责人是Connor Holmes

Connor去年从微软跳槽到了OpenAI。作为Sora项目的系统负责人,主要负责该项目的基础设施开发,致力于解决在推理和训练深度学习任务时遇到的系统效率问题。

核心贡献者共12人,其中有3个华人,他们分别是:Yufei Guo、Li Jing、Ricky Wang;其余成员是Clarence Ng、David Schnurr、Eric Luhman、Joe Taylor、Natalie Summers、Rohan Sahai、Ryan O'Rourke、Troy Luhman、Will DePue。

技术

在追求通用人工智能(AGI)的道路上,OpenAI一直致力于研发更高级的模型,Sora技术的创新点如下:

DiT架构:融合了扩散模型和Transformer架构的优势,取代了传统的U-Net架构。扩散是一种生成数据的过程,Sora从一段充满噪声的视频开始,通过多次去噪,逐步生成最终的样本;Transformer的优势在于它能够继承在语言等其他领域中所展现的扩展规律,因此Transformer架构的引入使得Sora可以具备强大的可扩展性,可以从大量数据中学习到复杂的视频关系。

统一的视觉表示:Sora采用压缩视频中的时空块作为基础单元进行处理。通过分析这些时空块,Sora能够在不同的时长、分辨率和比例的条件下保持高度一致性,提升了生成视频的质量。这使得它在面对各种视频格式时都能自如应对,无论是短小的垂直视频还是宽屏影片,Sora都能生成清晰且一致的视觉效果。

新兴的仿真能力:Sora不仅可以生成高质量视频,还能在时间和空间上保持一致性,模拟出逼真的3D场景和物理现象。它能在长时间段内维持内容的连续性,甚至能够仿真出数字世界的虚拟环境。这种强大的仿真能力让Sora在生成符合物理法则的动态视频时展现出无可比拟的潜力。

灵活的输入方式:Sora支持多种输入方式,不仅可以根据文本生成视频,还能够通过输入图像或现有的视频片段进行编辑。这为创作者提供了极大的灵活性,无论是生成全新内容还是对已有素材进行再创作,Sora都能提供强有力的支持。

虽然Sora在生成复杂对象方面显著提升,超越了先前的工作,但目前的技术仍有一定局限性。例如,视频中物体的持久存在性和更复杂的互动仍在开发中。在一个例子中,视频中的人正在踢足球,球在某一刻可能突然消失,再出现。这表明Sora目前可以处理简单的互动,但要实现更复杂、长久的物理互动,还需要进一步的优化和提升。

产品

2024年2月发布后,截至目前依然处于内测阶段。以下是官网展示视频,可以感受到在视频清晰度和细节保真度方面大幅提升,尤其在生成具有复杂运动或变化的场景方面展现出优势,能够生成更流畅且连贯的动态视频。

Prompt1: Animated scene features a close-up of a short fluffy monster kneeling beside a melting red candle. The art style is 3D and realistic, with a focus on lighting and texture. The mood of the painting is one of wonder and curiosity, as the monster gazes at the flame with wide eyes and open mouth. Its pose and expression convey a sense of innocence and playfulness, as if it is exploring the world around it for the first time. The use of warm colors and dramatic lighting further enhances the cozy atmosphere of the image.

译文:动画场景特写了一个短毛茸茸的怪物跪在一支融化的红色蜡烛旁边。艺术风格是3D和逼真的,重点在于光影和质感。这幅画的氛围充满了惊奇和好奇,因为怪物睁大眼睛、张开嘴巴凝视着火焰。它的姿势和表情传达出一种天真和顽皮的感觉,仿佛它第一次探索周围的世界。温暖的色彩和戏剧性的照明进一步增强了图像的温馨氛围。

Prompt2: A drone camera circles around a beautiful historic church built on a rocky outcropping along the Amalfi Coast, the view showcases historic and magnificent architectural details and tiered pathways and patios, waves are seen crashing against the rocks below as the view overlooks the horizon of the coastal waters and hilly landscapes of the Amalfi Coast Italy, several distant people are seen walking and enjoying vistas on patios of the dramatic ocean views, the warm glow of the afternoon sun creates a magical and romantic feeling to the scene, the view is stunning captured with beautiful photography.

译文:一架无人机摄像机围绕着阿马尔菲海岸沿线的岩石突出部分上建造的一座美丽的历史教堂旋转,视野展示了历史悠久且宏伟的建筑细节以及分层的路径和露台,可以看到海浪在下面的岩石上撞击,同时视野还俯瞰着意大利阿马尔菲海岸的水域和丘陵景观的地平线,远处可以看到一些人在露台上散步和欣赏戏剧性的海景,下午温暖的阳光为场景创造了一种神奇而浪漫的感觉,这个场景被美丽的摄影技术捕捉得令人惊叹。

05 后起之秀:快手、Minimax

快手-可灵

可灵的文字生成视频方面之前一直是弱项,但今天看来效果也不输Sora。

另外,在今年七月份的时候,ZP曾用图片和文字Promt测试过可灵最初的版本,1.0版图生视频效果是这样的:

再来看一组七月份测试的1.0版文生视频:

Prompt:Create a warm and cozy family gathering video, showing a family celebrating a birthday in the living room with cake, gifts, and laughter.

Prompt:Generate a video of a futuristic tech city, including skyscrapers, flying cars, and intelligent robots.

生成一个展示未来科技城市的视频,包括高楼大厦、飞行汽车和智能机器人。

其实当时在测试时,有一个直观感受是可灵模型的文字生成视频没有图片生成的效果好,如今看来效果的差异几乎没有了,且在清晰度、内容一致不崩坏性上进步飞速,可见可灵1.5版本在文生方面下了不少功夫。

这么一对比,会发现三个月过去,可灵1.5版本模型不仅在画质方面(1080p)有了大的提升,还让画面动态性、与Prompt一致性更高。如果说有什么缺点的话,那应该是生成时间了,相比于市面其他生成模型来说,可灵用时明显更多。但看到生成的视频质量如此之高,等待也是值得的。

Minimax-海螺AI视频

MiniMax上月发布的视频模型 abab-video-1,创作入口内嵌于海螺 AI 网页版。同样我们拿Sora的两例Prompt测试下。时长方面,6s的视频用时接近5分钟。

相比于Sora,海螺生成的视频时长会有些短,但在完成度、清晰度和对细节的把控(左边的毛流感和右边的建筑下的人物)做的也是非常到位了。

试一下两张图片生成视频的效果:(可上滑与可灵对比)

再试一下两段文字生成视频的效果:(Prompt同可灵)

通过对比,不难看出二者在图片生成的视频效果差不多,但在文字生成方面,海螺AI视频还是更胜一筹。

结合海内外网友的使用体验和评论,对比下来最直观的感受是目前国产的这两个大模型,可灵和海螺,堪称为继 Sora “期货”的后起之秀。中国团队后发而先至,目前世界上最好的视频生成模型还得是中国制造。

文章来源: